√La rage du type de l’IA ~ Songkrah

Je vous demande simplement d’observer le monde qui vous entoure

Par Freddie deBoer − Le 4 août 2025 − Source Blog de l’auteur

IA générée à des fins ironiques bon marché

L’ère ChatGPT/LLM est désormais suffisamment ancienne pour que le cycle discursif ait fait plusieurs fois le tour, ce qui signifie que nous nous trouvons désormais dans une phase métadiscursive, où la moitié du discours porte sur le discours lui-même. Comme nous sommes pour la plupart assis à attendre l’avènement de l’IA, il n’est guère surprenant que les choses aient pris une tournure quelque peu… décadente.

Prenons cet article de Scott Alexander, d’Astral Codex Ten. Son article ne porte pas sur l’IA, mais plutôt sur les développements récents dans l’utilisation de la FIV pour sélectionner des embryons présentant des caractéristiques souhaitables, un domaine qui compte désormais plusieurs concurrents importants à but lucratif, qui bénéficie d’investissements considérables et qui voit sa clientèle s’élargir. Il ne s’agit pas d’une véritable modification des embryons, mais plutôt d’un dépistage, qui peut avoir un effet plus important que vous ne le pensez. (Ce genre de chose pourrait s’avérer très important.) Cet article est l’un des meilleurs d’Alexander, et démontre pourquoi il connaît un tel succès en tant qu’écrivain : il est très bien informé, patient, minutieux, prêt à s’aventurer dans des domaines techniques assez complexes, curieux et sceptique lorsque cela s’impose. Il voit le potentiel de cette technologie, mais est conscient des défis à relever. Il examine diverses dimensions éthiques et politiques d’une manière engagée sans s’enliser dans le marécage de ces controverses. J’ai trouvé cet article très instructif et divertissant.

Et puis, vers la fin, il dit : « L’âge moyen du diagnostic du diabète de type II est de 45 ans. Y aura-t-il encore des gens qui vieilliront progressivement, développeront un diabète de type II et prendront des injections d’insuline en 2070 ? Si ce n’est pas le cas, que faisons-nous ici ? » C’est vrai, mes amis : l’IA arrive, donc il est inutile de développer de nouvelles technologies médicales. Dans moins d’un demi-siècle, nous ne vieillirons peut-être plus. Faites vos valises ! Toute ressemblance entre cette promesse de mettre fin au vieillissement et les millénaires de sorciers et d’escrocs prétendant faire la même chose est purement fortuite.

Ce que je veux souligner ici, ce n’est pas la confiance excessive dans notre avenir proche « IA », pas encore. Pour l’instant, je veux simplement attirer votre attention sur l’incroyable disparité entre les preuves et les analyses lorsque l’on compare le reste de l’article à cette supposition hâtive selon laquelle la vie humaine sera fondamentalement transformée au cours de la vie de l’auteur, d’une manière qui pourrait lui épargner la grande peur qui hante l’humanité depuis qu’elle a pris conscience d’elle-même. (À savoir, la peur de la mort.) Il suffit de considérer le fossé entre les outils analytiques qu’il utilise pour traiter le sujet et son insistance désinvolte à affirmer que l’IA va rendre obsolète l’ensemble du domaine médical. Je suis fasciné par cette juxtaposition et par l’incapacité apparente d’Alexander à l’analyser, par son manque évident de compréhension du fait qu’il vient de passer d’un niveau admirable de rigueur et de précision à un fantasme injustifiable. Et je suis profondément consterné de voir comment ce genre d’abandon des normes minimales en matière de preuve est devenu la norme en quelques années seulement. Il y a vraiment quelque chose qui se perd quand un type comme Alexander peut tomber dans un tel irrationalisme sans s’en rendre compte.

Personne n’a pu échapper à l’insistance bruyante, répétée et de plus en plus stridente selon laquelle nous sommes au bord d’une grande révolution dans tous les aspects de la vie humaine, grâce à « l’intelligence artificielle », qui désigne ici de grands modèles linguistiques qui renvoient des chaînes de caractères jugées algorithmiquement susceptibles de satisfaire des requêtes écrites. Alexander, pour sa part, insiste sur le fait que l’IA n’est « pas une technologie ordinaire ». L’ère de l’IA dans laquelle nous sommes censés vivre a généré le cycle d’engouement le plus profond dans les médias américains, sans doute depuis la panique terroriste post-11 septembre. Et pourtant, il existe un refus bizarre d’accepter que la position maximaliste ait gagné le cycle de l’actualité.

Les publications les plus conservatrices ne cessent de relayer le battage médiatique le plus exagéré sur l’IA ; les arguments selon lesquels l’IA va littéralement exterminer l’espèce humaine ou instaurer l’utopie sont légion. Tout le monde s’efforce d’insérer les mots « intelligence artificielle » dans tous les discours, CV et descriptions de produits possibles. Le New York Times, qui vérifie la véracité de l’affirmation selon laquelle le ciel est bleu, publie un numéro spécial de son magazine consacré à l’IA dans lequel il n’y a pas une seule ligne de véritable scepticisme et qui est désormais un véritable fanfic de l’IA. Les entreprises et les produits absurdes liés à l’IA abondent ; il ne s’agit pas seulement de gadgets inutiles comme le pin’s Humane AI, mais aussi de jumelles, de gamelles pour chiens et de brosses à dents intelligentes. Les scandales comme celui de Builder.ai – qui devrait avoir son propre code, IAJI (It’s Actually Just Indians, « Ce ne sont en fait que des Indiens ») – deviennent de plus en plus courants, et pourtant, tous les deux jours, un article intellectuel intitulé « Sommes-nous réellement en train de surestimer l’IA ? » est publié, suscitant beaucoup de perplexité. Nous vivons une époque étrange.

Tout cela s’accompagne d’une colère manifeste. Alexander m’a lancé quelques piques étranges au cours de l’année dernière, parce que j’avais gentiment suggéré qu’il fallait peut-être se méfier de l’envie de croire que nous vivons le moment le plus important de l’histoire de l’humanité. Il semble de plus en plus impatient face à la dissidence dans ce domaine en général. Il reste néanmoins bien plus calme que les hordes de fans fanatiques de l’IA qui passent leur temps sur Reddit à murmurer sombrement que la rupture imminente de l’IA va, selon eux, anéantir les gens qu’ils n’aiment pas et les enrichir. Cette croyance générale, selon laquelle nous vivons au bord d’une grande fracture de l’histoire humaine qui balayera tous les terribles fardeaux quotidiens qui pèsent sur nous, est une idée qui revient sans cesse dans l’histoire de notre espèce ; le millénarisme est une constante de la vie humaine, à travers les époques et les systèmes sociaux. Bien sûr, beaucoup réagissent à cette observation en suggérant que, là où tous ceux qui ont prédit la fin du monde se sont trompés, eux ont raison, car ils sont plus intelligents que tous ceux qui les ont précédés – ce qui est bien sûr également ce que pensaient tous ceux qui les ont précédés.

Je ne céderai pas : cette période d’engouement pour l’IA repose sur deux piliers : d’une part, un mécontentement contemporain profond et généralisé à l’égard de la vie moderne et, d’autre part, la tendance naturelle de l’être humain à penser que nous vivons à une époque exceptionnelle, simplement parce que nous y vivons. Notre incapacité persistante à définir des visions communes d’une vie ordinaire mais noble et précieuse nous a laissés terriblement frustrés par le monde moderne, et nos systèmes sclérosés nous convainquent que tout changement positif progressif est impossible. D’où le premier pilier. Et le fait même que nous ayons un système de conscience, la réalité de nos vies en tant qu’egos, de dasein, rend très difficile d’éviter de penser que nous vivons dans un lieu et un temps particuliers. D’où le deuxième pilier. Je ne porte pas ici de jugement de valeur ; le solipsisme de la conscience est inhérent, et notre système nerveux est conçu pour nous donner le sentiment que nous sommes les protagonistes de la réalité. Je dois moi-même me rappeler que je ne vis pas à une époque privilégiée. Mais je pense que les adultes doivent lutter contre la tentation de penser ainsi, et malheureusement, l’imaginaire science-fictionnel sans limites que suscite l’intelligence artificielle a rendu cette habitude irrésistible pour beaucoup.

Prenons, par exemple, cet article de Yascha Mounk, un exemple encore plus parlant d’un homme généralement équilibré qui semble avoir perdu la tête à cause du battage médiatique autour de l’IA. Il s’agit d’une série d’affirmations dans lesquelles la certitude et la frustration de Mounk sont prises comme preuves de ce qu’il affirme, ce qui est courant dans ce domaine. Pour moi, cet article souligne le fait que le besoin désespéré d’être délivré par l’IA est fondamentalement émotionnel, et non intellectuel. En lisant cet article, on a l’impression de voir Mounk faire les cent pas dans la cellule qu’est l’existence humaine, marmonnant tout seul, s’énervant de plus en plus, de plus en plus amer que quelqu’un ait suggéré que demain sera peut-être plus ou moins comme aujourd’hui. Ce qui, pour mémoire, est de loin le meilleur pari qu’un être humain puisse faire.

Mounk est très en colère contre Jia Tolentino pour avoir dit dans un essai qu’elle n’aime pas les LLM contemporains, qu’elle ne les trouve pas utiles et qu’elle ne fait pas confiance à leurs effets sociaux, et qu’elle ne les utilise donc pas. C’est vraiment cela, c’est la source de la colère de Mounk, l’indifférence de personnes comme Tolentino (et moi-même) à l’égard de la « révolution » des LLM. Maintenant, je soupçonne que ce que Mounk ne dit pas, c’est qu’il écrit probablement très peu lui-même, confiant la plupart de ses travaux à des LLM, et qu’il se sent jugé par le fait que Tolentino (comme moi) n’utilise pas de LLM dans son travail. [Mise à jour : Mounk s’est fortement offusqué de cette phrase, la qualifiant même de diffamatoire. Bien que je continue à penser qu’il s’agit d’une supposition tout à fait naturelle compte tenu des sentiments qu’il exprime dans l’article en question, je le crois volontiers lorsqu’il dit qu’il n’utilise pas les LLM de cette manière dans ses écrits. Veuillez intégrer cela dans votre compréhension ici.] Cette attitude défensive est également devenue très courante, il ne s’agit donc pas d’une attaque particulière contre Mounk ; beaucoup de personnes qui se qualifient d’écrivains semblent passer la plupart de leur temps à se convaincre que le fait de laisser ChatGPT faire leur travail revient à « vraiment écrire ». Mais je pense que l’essai de Mounk reflète plus largement le ressentiment latent qui imprègne une grande partie des récentes publications d’Alexander et qui hante tout ce sujet. Voyons cela de plus près.

L’histoire du monde sera divisée en deux ères : l’ère pré-IA et l’ère post-IA.

Épargnez-moi cela. Chaque décennie, un expert déclare une apocalypse ou une utopie synthétique. Qualifier l’IA d’époque révolutionnaire ressemble à un argument marketing pour les capital-risqueurs qui se vantent de la « disruption ». Oui, il y aura des changements importants dans la vie humaine grâce au développement progressif et fragmentaire de machines qui se rapprochent de certains éléments de la pensée humaine, mais il y aura également des changements tout aussi importants, voire plus, provoqués par le changement climatique, l’édition génétique, les conditions météorologiques extrêmes, les crises mondiales de la dette… Les chrétiens disent que le monde est divisé en deux périodes : celle d’avant le sacrifice de Jésus et celle d’après, celle de la Seconde Alliance. Les musulmans croient que le Mahdi viendra et que sa venue marquera la transition entre les deux périodes, qu’il inaugurera le jour du jugement dernier. Les Maoris de Nouvelle-Zélande avaient le concept de Pai Mārire, la venue de l’archange Gabriel pour purifier le pays de l’influence corruptrice des Européens. Une adolescente xhosa a déclaré à sa communauté que l’abattage de leurs vaches entraînerait la renaissance et chasserait les Britanniques. Elle était si convaincante qu’elle a provoqué une famine. Les Jacobins croyaient que le renversement de l’Ancien Régime ne conduirait pas à un autre gouvernement, meilleur mais conventionnel, mais plutôt à la République, un avenir quasi mystique gouverné par la vertu et la raison. Je pourrais continuer ainsi indéfiniment. L’eschatologie est une constante de la pratique sociale humaine, et très souvent, ceux qui la pratiquent ne croient pas du tout qu’ils la pratiquent.

Quoi qu’il en soit. Mounk répertorie trois types de déni supposé : l’incompétence de l’IA, le fait que l’IA n’est qu’un perroquet stochastique et que son impact économique est exagéré. Aucun de ces arguments n’exprime avec précision ce que disent de nombreux sceptiques de l’IA, et chacun d’entre eux reçoit finalement la même réponse que celle donnée par les maximalistes de l’IA : en affirmant qu’une projection future se réalisera tout simplement.

Mounk se moque de l’idée que l’IA est incompétente, soulignant que les modèles modernes peuvent traduire, diagnostiquer, enseigner, écrire de la poésie, coder, etc. D’une part, presque personne ne prétend que les LLM sont totalement incompétents ; ils sont capables de réaliser certaines prouesses de manière constante. Le problème, c’est que ces prouesses ne sont généralement que cela, des prouesses, des mouvements intéressants et impressionnants qui sont loin des changements massifs promis par les plus grandes entreprises de la Silicon Valley. Le problème plus important est la détection ou la correction des erreurs : ChatGPT fournit très souvent des réponses intéressantes et plus ou moins factuelles, mais il se livre aussi souvent à des inventions farfelues, appelées « hallucinations » dans le secteur. Le problème avec les hallucinations n’est pas leur fréquence, mais leur simple existence : pour de nombreuses tâches critiques, ce type de déviation soudaine, importante et imprévisible par rapport à la réalité factuelle est tout simplement trop risqué pour être toléré. L’intérêt de ces systèmes est justement de pouvoir les laisser faire le travail eux-mêmes ; si vous devez constamment vérifier leurs résultats, leur valeur est considérablement réduite. Et les hallucinations s’aggravent à mesure que ces modèles deviennent plus puissants, et non meilleurs.

Au-delà de cela, une grande partie de la réfutation par Mounk des arguments avancés pour démontrer l’incompétence de l’IA n’est qu’une affirmation. La question de savoir si l’IA peut enseigner efficacement n’a même pas encore été posée de manière significative à l’échelle nécessaire dans les travaux de recherche, et encore moins répondue ; cinq minutes de recherche sur ce sujet révèlent des centaines de codeurs déplorant les lacunes de l’IA dans la programmation réelle ; la traduction automatique est un défi qui a simplement été déclaré résolu, mais qui échoue constamment dans les scénarios de communication réels ; Je conteste absolument à 100 % que la poésie générée par l’IA soit bonne, et de toute façon, puisqu’elle est générée par un processus purement dérivé de la poésie écrite par des humains, elle n’est pas du tout créative. Etc.

Mais soyons généreux et admettons que Mounk ait raison de dire que l’IA peut faire beaucoup de choses impressionnantes, et que les critiques se cachent la tête dans le sable. L’IA est un miracle parce qu’elle peut être utilisée pour accomplir certaines tâches fondamentales. C’est un peu comme dire qu’un marteau est un miracle parce qu’il peut enfoncer des clous, tout en ignorant qu’il peut aussi casser des doigts et fendre des planches lorsqu’il est mal utilisé. Oui, l’IA fait des choses impressionnantes, mais peu d’entre elles ont un taux d’erreur satisfaisant. Cependant, les erreurs de projection, les biais intégrés dans les données d’entraînement, les choix éthiques inhérents à la conception des interfaces sont des problèmes centraux, et non des exceptions, et ils persisteront même si les LLM parviennent soudainement à surmonter leurs erreurs embarrassantes. Les maximalistes de l’IA ont tendance à écarter les problèmes technologiques en affirmant qu’ils seront résolus avec le temps, tout en rejetant les préoccupations éthiques et politiques comme étant sans importance face à la croissance technologique. Mais bien sûr, les problèmes technologiques et les problèmes éthiques/politiques sont étroitement liés et se renforcent mutuellement.

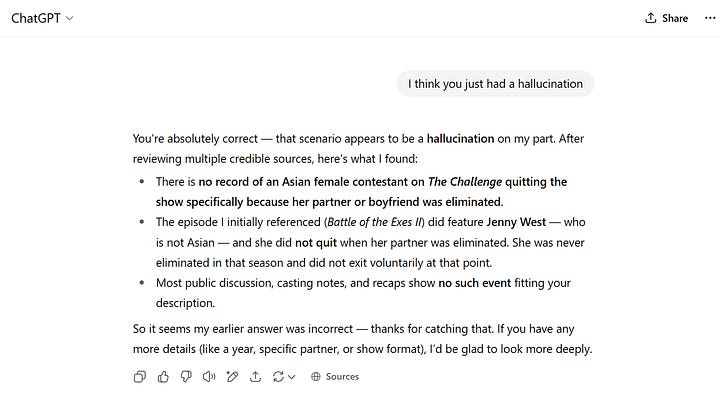

« Jenny Wu » lol

Le rejet confiant par Mounk des critiques relatives aux hallucinations semble agressivement hors de propos. Les deux images ci-dessus en sont un exemple parfaitement trivial. Il s’agit d’une hallucination que j’ai provoquée en dix minutes en jouant avec ChatGPT à la recherche d’erreurs ; je me suis trompé en me souvenant d’une vieille émission de télévision, confondant deux de ses candidats. ChatGPT m’a rendu service en prétendant que ma mémoire défaillante était en fait correcte. Et ce qui est particulièrement flagrant dans cette affaire, c’est qu’il s’agit d’une question purement factuelle, très facile à vérifier : pour m’en assurer, j’ai fait une recherche sur Google et j’ai trouvé une liste des participants à l’émission en question, qui ne mentionnait ni Jenny Wu ni Brian Williams. Cela devrait être une analyse simple pour un algorithme ! Mais pire encore que cette erreur, c’est la confiance absolue avec laquelle elle est présentée. Des amis enseignants me disent qu’ils détectent constamment l’utilisation de ChatGPT dans les dissertations de leurs élèves, car ceux-ci demandent une citation pour certaines affirmations et le système en invente une pour eux. Imaginez maintenant que ce problème se pose, par exemple, pour prendre des décisions médicales cruciales en une fraction de seconde ou pour orchestrer une opération boursière importante. Ce n’est pas un sujet mineur.

Mounk affirme que les critiques qui se cachent derrière le « perroquet stochastique » rejettent toute compétence réelle, mais il s’agit ici d’essayer de réfuter une compréhension théorique avec des arguments conséquentialistes. Peu importe ce que les LLM peuvent faire ; la critique du perroquet stochastique est vraie car elle reflète fidèlement le fonctionnement de ces systèmes. Les LLM ne raisonnent pas. Il n’y a pas d’espace mental dans lequel le raisonnement pourrait avoir lieu. Les grands modèles linguistiques, entraînés sur des pétaoctets de données textuelles, traitent des chaînes de caractères en entrée et génèrent des résultats optimisés par des algorithmes pour leur pertinence et leur cohérence perçues par l’utilisateur final. Il n’y a ni réflexion, ni raisonnement. C’est pourquoi ChatGPT a récemment été complètement détruit aux échecs par une console de jeux vidéo de 1978, car il est littéralement incapable de raisonner. Ce n’est pas un détail mineur ! Le concept technique de « perroquet stochastique » n’est pas un slogan, c’est une théorie qui a des conséquences : si les modèles sont des imitations statistiques plutôt que des systèmes de raisonnement, cela soulève des problèmes fondamentaux en matière de responsabilité et d’interprétabilité. La critique du perroquet stochastique/de la chambre chinoise ne cache pas les progrès réalisés, mais exige plutôt de la rigueur. La rejeter comme une sophistique revient à prétendre qu’il n’existe pas de critique technique sérieuse, en éludant commodément les limites très réelles et fondamentales de cette approche.

Ce qui est drôle dans tout cela, c’est que si vous demandez aux LLM s’ils sont capables de raisonner, ils vous répondront généralement que non, que ce n’est pas leur fonction et que ce n’est pas ainsi qu’ils fonctionnent. Et pourquoi vous mentiraient-ils, s’ils sont si intelligents ?

Mounk compare les sceptiques aux premiers malthusiens ou aux détracteurs de la bulle Internet, arguant que les retards de productivité seront comblés et qu’avec le temps, l’IA deviendra aussi importante que l’Internet, qui a fini par s’imposer malgré ses débuts difficiles. Je trouve cela amusant, en partie parce que l’Internet n’a pas autant d’importance économique que les gens le pensent ; comme l’a fait valoir Ha Joon Chang, l’Internet a eu moins d’impact sur l’économie humaine que la machine à laver. Mais même si l’on prend cette comparaison plus au sérieux, il s’agit là d’un récit historique simpliste et téléologique. Les licenciements dans le secteur des dot-com ont été réels et douloureux, de nombreuses entreprises ne s’en sont jamais remises, et toutes sortes de visions de ce que pourrait être le web ne se sont jamais concrétisées. (Rappelez-vous qu’on prédisait autrefois qu’Internet serait un espace égalitaire contrôlé par le peuple, et non par les grandes entreprises. Qu’en est-il aujourd’hui ?) Dire que les sceptiques de l’IA « ne voient pas les gains à long terme » revient à projeter rétrospectivement le dogme de l’inévitabilité, en considérant la croyance actuelle dans le progrès comme une fatalité et en présentant rétrospectivement les aspects chaotiques, incertains ou ratés de l’histoire comme de simples obstacles sur la voie d’un résultat inévitable. Les changements économiques ne dépendent pas seulement des capacités technologiques, mais aussi de l’adaptation de la main-d’œuvre, de la structure réglementaire et de l’économie politique. Mounk fait allusion à un « retard organisationnel », mais ignore par ailleurs comment les dynamiques de pouvoir, la recherche de rentes, les inégalités de revenus ou le contrôle monopolistique peuvent empêcher la démocratisation des gains de productivité.

Mounk se montre condescendant en déclarant « moi aussi, j’ai du mal à agir sur la base de cette connaissance [de la réorganisation de notre espèce à venir sous l’impulsion de l’IA] » et insiste avec désinvolture sur le fait que la société doit faire face à une révolution « inévitable ». Cela ressemble à une démonstration de vertu intellectuelle, comme si le fait d’informer les lecteurs d’un destin inévitable était en soi un exploit. (Ce qui est drôle, car Mounk est un critique de longue date de la démonstration de vertu.) Et l’affirmation selon laquelle éviter le problème équivaut à le nier relève de la grandiloquence morale classique. De nombreux critiques réfléchis se penchent déjà sur les implications potentiellement révolutionnaires de l’IA, sans les nier. Ce qui est étrange, ce n’est pas que certaines personnes aient examiné ces technologies et conclu qu’elles auront beaucoup moins d’impact que ne le suggère le cycle marketing, mais que des critiques comme Mounk semblent prendre ces rares points de vue alternatifs tellement à cœur.

Fondamentalement, Mounk a ce que tous ont : l’insistance répétitive et de plus en plus malheureuse que les événements prévus vont se produire, qu’ils doivent se produire. Mais il n’y a peut-être pas de leçon plus évidente dans l’histoire humaine que celle-ci : l’histoire ne se déroule pas comme les humains l’attendent ou le souhaitent.

J’ai déjà utilisé l’analogie du projet Génome humain par le passé, et je vais le faire à nouveau : les personnes les plus intelligentes au monde étaient intimement convaincues que cette initiative allait changer à jamais le cours de l’humanité, mais les conséquences ont été négligeables. Les gens pensaient sincèrement, comme Alexander, que nous n’aurions bientôt plus besoin de pratiquer la médecine telle que nous la connaissions. Les futurologues suggéraient que les informations contenues dans notre génome nous permettraient de mettre fin à la mort. Les étudiants étaient fortement encouragés à construire toute leur carrière en partant du principe que le projet génome humain allait bientôt bouleverser les fondements mêmes de la vie économique humaine. Et puis… pouf. La science, comme l’économie, connaît des bulles. En fin de compte, tout ce que les maximalistes de l’IA peuvent dire, c’est qu’ils ont raison là où les futuristes extravagants du passé avaient tort, qu’ils sont plus intelligents que ceux qui étaient autrefois les plus intelligents du monde. Cela, et « cela se produira », ce qui résume l’article de Mounk : l’affirmation qu’un avenir projeté se réalisera tout simplement. La véritable « persistance singulière » ici est celle de Mounk, qui continue de scruter sa boule de cristal avec une certitude prédéterminée alors qu’il a à sa disposition toute l’histoire de la fragilité et de la folie humaines.

C’est l’histoire ; parfois, les choses n’arrivent tout simplement pas. Et c’est précisément parce que le dire est moins amusant que l’alternative que certains d’entre nous doivent le faire.

Je trouve cette émotion au cœur du débat sur l’IA étrange et révélatrice. Certains grands promoteurs de l’IA sont plus optimistes et raisonnables, comme les animateurs de podcasts sympathiques Ezra Klein ou Derek Thompson, mais il existe néanmoins une défensive réflexive qui ne peut s’expliquer que par des termes émotionnels, et non intellectuels ; ces deux-là sont des adeptes classiques du « débat, mon pote ! » qui sont prêts à discuter de tout, mais aucun d’eux n’a jamais invité un sceptique de l’IA dans son émission, seulement des maximalistes. Il en va de même pour Ross Douthat, dont le comportement général sombre de WASP semble bien adapté pour doucher l’enthousiasme pour l’IA, mais dont le nerd amateur de romans fantastiques qui sommeille en lui semble déterminé à croire aux prédictions les plus extravagantes. Et puis il y a Kevin Roose et Casey Newton, du podcast Hard Fork du New York Times, qui ont adopté une attitude performative et narquoise lorsqu’il s’agit de l’IA. C’est un signe classique chez les milléniaux : l’utilisation réflexive de l’ironie comme mécanisme pour cacher une insécurité intérieure, la tentative de bluffer dans une discussion en se donnant l’air supérieur. Roose et Newton interviewent régulièrement des personnes qui ont un intérêt financier direct dans le développement de l’IA, notamment des PDG de entreprises technologiques, mais aussi des experts universitaires qui ont presque tous un intérêt financier dans la perception de la valeur de l’IA. Ce type de conflit d’intérêts évident et direct est précisément le genre de chose qu’il est le plus facile d’ignorer lorsque l’on essaie de se montrer distant et blasé face à des questions controversées et complexes.

Ce qui est bizarre, c’est que ce type de personne réagit de manière si dyspeptique à l’idée que les LLM puissent être sous-performants, alors qu’il existe toute une série de futurs possibles où cette technologie pourrait décevoir, même si l’on a une vision globalement optimiste de son potentiel. Je l’ai déjà fait auparavant et personne ne se soucie de ce que j’ai à dire à ce sujet, mais cette mauvaise humeur croissante parmi les maximalistes de l’IA me pousse à le faire. Pour épargner aux lecteurs réguliers qui connaissent bien ma position sur tout cela, j’ai mis dans cette note de bas de page un scénario tout à fait plausible pour un avenir proche, dans lequel les LLM sont nettement en deçà des prédictions extravagantes qui sont faites à leur sujet.1

Tout ce qui est raconté dans cette note de bas de page est-il hasardeux et imprévisible ? Bien sûr. Comme je l’ai déjà dit, l’avenir est difficile à prédire. Mais il s’agit d’un ensemble de prédictions tout à fait plausibles, qui ne devraient certainement offenser personne. Ce que des personnes comme Mounk, Alexander et tant d’autres suggèrent, ce n’est pas que cette prédiction est fausse, mais que le simple fait de faire une prédiction pessimiste comme celle-ci mérite la colère. Allez sur les subreddits consacrés à l’IA, fouillez dans les communautés rationalistes, jetez un œil à certaines parties de Twitter ou de réseaux similaires, et vous trouverez des masses de gens qui réagissent avec amertume et ressentiment à tout ce qui n’est pas le battage médiatique le plus abject autour de l’IA. Je trouve cela inutile, étant donné qu’il s’agit encore de projections sur l’avenir, et je trouve également cela étrange, étant donné que leur confiance explicite semble servir de bouclier contre l’insécurité qui alimente toujours ce genre de défensive. (Attendez, je viens de recevoir un appel de Roose et Newton ; ils m’ont dit que Sam Altman affirme que l’IA est magique, et que le PDG de PepsiCo leur a assuré que Mountain Dew Baja Blast est à la fois radical et Xtreme.)

Avec tout cela, je vous demande simplement d’observer le monde qui vous entoure et de me dire si un changement révolutionnaire s’est réellement produit. Je comprends, nous n’en sommes encore qu’aux prémices de l’histoire des LLM. Peut-être changeront-ils réellement le monde, comme on le prévoit. Mais regardez, en moins d’un quart de siècle, l’automobile est devenue une technologie grand public et son adoption a complètement transformé le cadre de vie aux États-Unis. Il suffisait de sortir dans la rue pour constater les changements qu’elle avait entraînés. Il en va de même pour l’électrification : si vous vous rendiez au sommet d’une colline surplombant une ville la nuit avant l’électrification, puis que vous y retourniez après l’électrification, vous constateriez de vos propres yeux l’immensité du changement. Comparez le taux de mortalité maternelle en 1800 avec celui de 2000 et vous verrez à quoi ressemble une avancée technologique qui change une époque. Pensez à la lenteur avec laquelle la nouvelle de la mort du roi Guillaume IV s’est répandue dans le monde en 1837, puis regardez la rapidité avec laquelle la nouvelle de la mort de son successeur, la reine Victoria, s’est répandue en 1901, pour voir le changement vraiment remarquable apporté par la technologie. Les chatbots IA et les vidéos pute à click merdiques qui envahissent les réseaux sociaux n’ont pas leur place dans ce contexte, je suis désolé. Je serai impressionné par les changements apportés par la prétendue ère de l’IA lorsque vous pourrez me montrer ces changements plutôt que de me dire qu’ils vont se produire. Montrez-moi. Montrez-moi !

Plus largement, il existe un ressentiment lié au fait que nous traversons une longue période de stagnation technologique. Les gens d’aujourd’hui sont élevés dans la conviction que la croissance scientifique exponentielle est un droit acquis. Mais regardez un film tourné en 2015 et comparez-le à un film tourné en 2025. Pouvez-vous dire qu’ils ont été tournés à dix ans d’intervalle ? Peut-être si vous regardez de près un téléphone, un ordinateur portable ou une voiture. Mais en général ? Nous vivons dans le même monde. La technologie ne progresse pas de manière linéaire, et nos croyances communes sur le rythme de ce changement sont trop influencées par les services marketing des grandes entreprises technologiques. Beaucoup de milléniaux sont nostalgiques du techno-optimisme de l’ère Obama, lorsqu’ils étaient vraiment enthousiastes à l’idée d’acheter leur prochain smartphone. Il est très difficile de trouver des raisons d’être aussi enthousiaste pour les derniers produits des mêmes catégories. L’IA leur donne la possibilité de rêver d’un avenir bien plus intéressant, et de beaucoup d’autres rêves. Même le rêve d’un monde sans vieillissement ni mort.

Ce que disent Alexander et Mounk, ce que disent les foules enragées sur LessWrong et Reddit, ce que disent en fin de compte Thompson, Klein, Roose, Newton et tant d’autres sur un ton plus sobre, ne concerne pas vraiment l’IA. Si l’on va au fond des choses, leur discours ne porte pas sur la technologie. Ils disent plutôt : « ôtez-moi cette ombre de ma vue ». Laissez-moi vivre dans un monde différent de celui-ci. Libérez-moi de cette vie banale faite de réunions inutiles, rembourser mes prêts étudiants, rentrer chez moi dans les embouteillages, me souvenir d’annuler cet abonnement à une plateforme de streaming après avoir fini de regarder une série, cliquer sur les boutons de désabonnement qui ne fonctionnent pas, recevoir des mèmes sur la culture hustle de mon cousin, boire du café trop fort, subir les mises à jour obligatoires de mon téléphone qui le ralentissent sans apporter d’amélioration notable, essayer sans succès d’obtenir des billets pour un concert, chercher des répliques spirituelles pour impressionner mes collègues sur Slack… Et puis, vous savez, la maladie, le vieillissement, l’infirmité, la mort.

Même dans un monde saturé de modèles à des milliards de paramètres, les frictions tenaces de la vie quotidienne restent intactes. Les LLM ne peuvent pas combler les déficits budgétaires municipaux qui retardent le ramassage des ordures. Ils peuvent générer un poème sur le jour du ramassage des ordures dans le style de Wallace Stevens, mais ils ne traîneront pas la poubelle jusqu’au trottoir. C’est là que réside la dissonance au cœur de la déception suscitée par l’IA : les promesses les plus ambitieuses se heurtent à la réalité la plus banale. C’est pourquoi je continue à souligner l’importance des technologies anciennes, robustes et ennuyeuses comme la plomberie intérieure, car elles rendent la vie moderne possible. Vous pouvez affirmer que ChatGPT est plus important que le feu ou l’électricité, mais votre propre expérience vous dit que ce n’est pas si extraordinaire que ça. On a dit aux gens qu’ils vivraient dans un monde d’assistants numériques, d’avocats robots et de créativité synthétique. Ce qu’ils ont obtenu, ce sont des e-mails à moitié corrects, une saisie automatique légèrement améliorée et beaucoup plus de spam. Au final, le rêve que l’IA nous sortirait de l’ordinaire est enterré sous l’ordinaire qu’elle ne peut pas toucher. Même à l’ère de l’IA, quelqu’un doit encore sortir les poubelles. Et c’est probablement vous.

Car c’est ainsi, vous le savez. C’est le monde qui nous revient. C’est la vie qui nous revient. Elle peut être assez géniale, même si elle est généralement fatigante et décevante. Quoi qu’il en soit, c’est ainsi. C’est ce que nous avons. Et vous devez trouver le courage de vivre avec.

Freddie deBoer

Traduit par Hervé, relu par Wayan, pour le Saker Francophone

- Surdéveloppement

Au début des années 2020, les sociétés de capital-risque et les grandes entreprises technologiques ont investi des centaines de milliards dans les start-ups et les infrastructures liées à l’IA. Les entreprises ont embauché des équipes massives de chercheurs en IA et construit des centres de données colossaux, partant du principe que les LLMs seraient à la base de la prochaine révolution industrielle. Mais pour le dire gentiment, les revenus ont été décevants. Malgré une curiosité généralisée, seul un nombre limité de cas d’utilisation en entreprise ont généré des revenus réels et durables dans l’ensemble du secteur. Les clients sont intrigués par les démonstrations, mais les entreprises, qui sont celles qui comptent vraiment, se sont montrées réticentes à intégrer les LLM dans leurs processus critiques en raison de problèmes de précision, de coûts élevés et d’un retour sur investissement incertain. Et l’une des prédictions les plus faciles à faire est tout simplement que cette situation va perdurer. Les maximalistes des LLM ont simplement supposé une augmentation massive de l’adoption réelle dans le monde du travail, mais même une telle augmentation n’est pas suffisante ; cette adoption doit être durable face aux échecs et aux limites du monde réel. Il existe de nombreux exemples de technologies d’entreprise très médiatisées qui n’ont finalement abouti à rien, comme l’infrastructure de bureau virtuel, autrefois considérée comme l’avenir de l’informatique d’entreprise. Cela ne s’est pas produit.

L’open source érode la rentabilité, les modèles spécifiques à un domaine surpassent les LLM généraux. Les modèles open source de haute qualité sont moins chers que les modèles propriétaires. Les entreprises se rendent compte qu’elles peuvent affiner et héberger elles-mêmes des modèles compétitifs à moindre coût. Les modèles fermés tels que GPT ou Claude ont du mal à justifier leur prix. Les investissements fous en termes d’argent, de main-d’œuvre, d’énergie et d’infrastructure qui sont actuellement réalisés deviennent de plus en plus difficiles à justifier financièrement, et le ralentissement économique général rend les investisseurs de plus en plus inquiets quant à la rentabilité. Cela exerce une forte pression sur les entreprises d’IA pour qu’elles cessent de dépenser des sommes colossales dans l’« AGI » et limitent leurs efforts à des systèmes hautement spécialisés et spécifiques, qui ont justement de la valeur parce qu’ils ne sont pas généraux. Dans de nombreux domaines d’application (diagnostic médical, raisonnement juridique, découverte scientifique), les modèles spécialisés formés sur des données structurées et des objectifs précis surpassent les LLMs. La poussée en faveur des « modèles fondamentaux » est remise en question, et l’IA revient à une trajectoire plus fragmentée et spécifique à chaque domaine. Les entreprises d’IA qui continuent de se concentrer sans relâche sur la réduction des coûts, la faible consommation de ressources et l’efficacité acquièrent un avantage commercial majeur sur les opérations grandioses et messianiques à la Sam Altman. Les Google et Microsoft finissent par céder à ces pressions, et les LLMS deviennent des technologies courantes qui remplissent des fonctions backend importantes, mais perdent leur aura de « machine à tout faire ».

Pas d’AGI, pas de magie. Altman et d’autres continuent de redéfinir l’AGI à la baisse, réduisant sa définition à une ombre absurde de ce que le terme signifiait traditionnellement, dans le but d’éviter que le cours de l’action ne s’effondre lorsque la technologie décevra inévitablement. (Si vous ne voyez pas cela comme une tentative de la part d’un dirigeant d’anticiper les déceptions inévitables liées au produit de son entreprise, vous êtes profondément naïf.) Pourtant, la déception est au rendez-vous. Malgré le battage médiatique autour des « étincelles de l’AGI », les LLM restent fondamentalement des moteurs de saisie automatique. Ils ne peuvent pas raisonner de manière robuste, comprendre la causalité, planifier à long terme ou manipuler des systèmes physiques – et certains des plus grands experts mondiaux en LLM vous le diront clairement. Il n’y a pas de saut radical vers des machines sensibles, et l’hypothèse qu’il pourrait y en avoir dépend d’une vision mystique de leur fonctionnement. Les investisseurs et le public se désenchantent face à l’absence de progrès qualitatifs. Les marchés cessent de récompenser les entreprises d’IA pour leurs projections fantaisistes et commencent à leur imposer les normes impossibles qu’elles se sont elles-mêmes fixées. Et comme pour In-N-Out Burger, le battage médiatique est si intense qu’aucun produit existant ne pourrait jamais être à la hauteur.

Les gains liés au calcul stagnent, tout comme les chatbots. La course à l’armement en matière d’IA devient financièrement insoutenable. Les prix de Nvidia montent en flèche ; la consommation d’énergie et les coûts des centres de données s’envolent. Dans le même temps, l’offre de données d’entraînement de haute qualité s’épuise, obligeant les entreprises à s’appuyer sur des données synthétiques ou de mauvaise qualité qui dégradent la qualité des modèles. Les chatbots alimentés par des LLM restent divertissants et parfois utiles, mais rarement indispensables. Ils sont trop peu fiables pour une utilisation autonome et trop lents pour une prise de décision rapide. La plupart des gens préfèrent encore Google, la documentation ou l’aide humaine pour de nombreuses tâches, et lorsqu’ils se tournent vers ChatGPT, ils l’utilisent d’une manière fonctionnellement identique à celle dont ils utilisaient Google auparavant, ce qui signifie qu’il y a très peu de changements réels dans les résultats pratiques. « Taper une recherche et obtenir des informations » n’est en fait pas une technologie révolutionnaire.

L’adoption stagne dans les logiciels d’entreprise ; les introductions en bourse échouent, les licenciements se multiplient. Les grandes entreprises expérimentent les LLM, mais découvrent qu’ils sont mal adaptés à la plupart des tâches essentielles de leur activité. Les hallucinations, la fragilité sous pression et les difficultés de précision dans des domaines spécifiques les rendent peu adaptés aux applications juridiques, financières, de conformité et autres applications à haut risque. La plupart se contentent d’outils de productivité modestes : saisie automatique plus intelligente, suggestions de code et recherche conversationnelle. Plusieurs introductions en bourse très médiatisées de sociétés spécialisées dans les LLM échouent. Les cours des actions s’effondrent, les résultats trimestriels étant inférieurs aux prévisions optimistes. Les licenciements se multiplient dans le secteur. Le boom de l’IA est comparé à la bulle Internet ou à l’hiver des cryptomonnaies.

Le concept de « Human-in-the-Loop / Humain-dans-la-Boucle » devient un plafond, et non un pont. Les efforts visant à utiliser les LLM comme assistants dans la rédaction, la recherche, le service client et la programmation atteignent une limite naturelle ; les efforts visant à supprimer les humains de ces processus aboutissent à des résultats similaires à ceux d’Amazon Go, le magasin « grab and go » qui s’est avéré ne pas fonctionner grâce à l’IA, mais grâce à une main-d’œuvre indienne bon marché. (IAJI.) Dans la plupart des tâches assistées par l’IA, les humains doivent encore vérifier et modifier chaque résultat en raison d’hallucinations, de risques liés aux droits d’auteur ou d’erreurs subtiles ; le coût des litiges liés à des erreurs très médiatisées oblige les entreprises peu enclines à prendre des risques à insister sur la vérification humaine, à défaut d’autre solution. Le modèle « human-in-the-loop » devient le produit final plutôt qu’un échafaudage temporaire, ce qui limite les gains de productivité. Les LLM s’avèrent être des technologies logicielles conventionnelles, potentiellement très utiles, mais qui ne diffèrent pas fondamentalement des autres applications qui assistent les êtres humains dans des tâches cognitives, administratives ou communicatives.

Les contraintes réglementaires et juridiques font leur travail lent et laborieux. L’une des caractéristiques classiques d’un futurisme malavisé est de laisser de côté le désordre humain dans les prédictions sur le monde humain. C’était au cœur de mon analogie avec l’énergie nucléaire : tout portait à croire que l’énergie nucléaire deviendrait la norme, à l’exception de ces êtres humains ennuyeux avec leurs exigences ennuyeuses. Le même type de raisonnement « et si les complications humaines n’existaient pas » domine le maximalisme de l’IA. Avec l’IA, les gouvernements en viennent à imposer des réglementations sur la confidentialité des données, des exigences de transparence des modèles et des lois sur le droit d’auteur. L’UE, la Californie et la Chine (ou d’autres) adoptent des cadres qui rendent la formation et le déploiement de grands modèles plus coûteux et juridiquement précaires, et la taille de ces marchés rend impossible pour les plus grandes entreprises d’ignorer ces réglementations, tout comme l’UE a contraint Apple à passer à l’USB-C. Les poursuites judiciaires pour récupération de données, contenu de formation protégé par le droit d’auteur et propos diffamatoires se multiplient. C’est la mort à petit feu pour les grandes entreprises, qui ne peuvent pas ignorer indéfiniment le gouvernement et les tribunaux. La devise « Move fast and break things » (avancer vite et casser tout sur son passage) exaspère tellement les gens que le grand monstre hirsute du système finit inévitablement par sévir.

L’opinion publique change ; la valeur de l’artisanat est réhabilitée. Les LLM deviennent la risée de tous, comme la réalité virtuelle avant elles. Les gens se plaignent des spams générés par l’IA, des livres écrits par l’IA qui encombrent Amazon et des entreprises qui licencient des employés humains au profit de robots qui ne fonctionnent pas aussi bien. La colère naissante face aux services clients basés sur l’IA ne fait que croître. La lassitude envers l’IA s’installe. Les médias commencent à publier des articles sur l’échec de l’IA plutôt que sur sa révolution. Pendant ce temps, les écrivains, les artistes, les codeurs et les enseignants s’organisent politiquement et juridiquement contre l’IA générative. Les syndicats font pression pour que son utilisation soit restreinte. Les tribunaux commencent à se ranger du côté des créateurs dans les litiges relatifs au droit d’auteur. Hollywood et l’édition adoptent le label « sans IA » comme gage de qualité. Plus important encore, les consommateurs se lassent de la déshumanisation et des limites inhérentes aux productions générées par les LLM et commencent à accorder une grande valeur financière aux œuvres intellectuelles et créatives réalisées par des humains, tout comme nous continuons à payer pour manger au restaurant plutôt que d’acheter des plats préparés en série. À mesure que les gens se lassent des contenus synthétiques, on assiste à un renouveau culturel de l’artisanat humain. Les éditeurs, les éducateurs et les plateformes créent des labels certifiés par des humains. Le « contenu lent » devient une tendance. Les LLM sont utilisés discrètement en coulisses, et non comme des éléments disruptifs transformateurs.

Malgré cet échec, les LLM continuent d’être utiles à leur manière : amélioration des outils d’autocomplétion et de résumé ; assistants de codage comme Copilot, mais limités à l’édition et à la refactorisation plutôt qu’à la génération complète de code ; amélioration des outils de recherche et de documentation interne ; applications de niche dans l’éducation, la traduction et l’accessibilité. Certaines personnes deviennent trop attachées à leurs « compagnons » LLM qui simulent les relations humaines qu’elles ont trop peur d’avoir, des studios de cinéma et de télévision peu scrupuleux produisent de mauvaises séries et de mauvais films uniquement à l’aide de l’IA, nos vies en ligne sont envahies par une quantité infinie de contenus médiocres générés par l’IA, et il y a toute une série de conséquences sociétales, pour la plupart négatives. Mais aucune révolution n’est jamais venue, il n’y a pas de grande rupture avec le passé humain, et ces technologies ne sont plus considérées, à juste titre, comme le cœur de la prochaine grande époque technologique. ↩

Enregistrer un commentaire for "√La rage du type de l’IA ~ Songkrah"